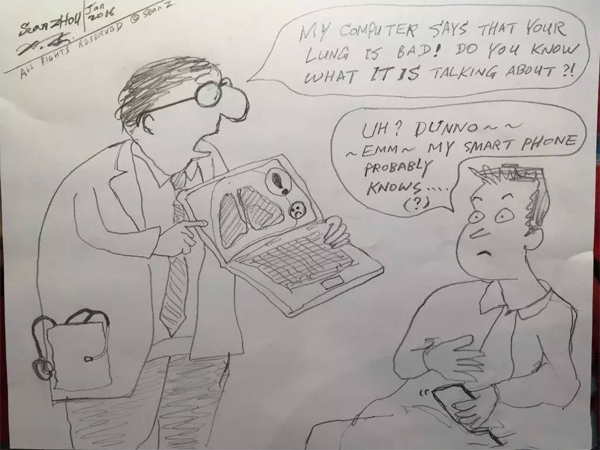

医生说:“我这个计算机说你的肺有问题,你知道它在说啥吗?”

病人说:“啊?我也不知道呀!嗯~~我的智能手机应该会知道吧(?)。”

一、引言

去年(2016)画这个漫画之意,一方面想说医生可能会越来越依赖、甚至落后于人工智能(Artificial Intelligence orAI);另一方面,智能手机或者智能穿戴设备天天跟踪监测我们的身体状况,对我们的生活和健康的影响也应该会越来越大。

但是画中的医生或者病人都不是人工智能的“惊喜的快乐用户”:有些医生担心人工智能工作得太好了,会抢走自己的饭碗;如果工作得不好呢,又可能会象一个黑箱一样,给出一些莫名其妙的、不可理喻的建议,让人无所适从。从病人的角度来看,大数据、大信息已经要将我们淹没,而人工智能则像一个外星人一样,给人带来一种莫名的距离感甚至恐惧感。

那么,如果有一个横轴代表欣喜、纵轴代表担忧的“情绪空间”(mood map), 你是在空间里哪一点上呢?作为一个业中人,我欣喜多于担忧;而投资界看上去比我还要乐观得多。

工业界的热情加上投资界的追捧对人工智能的发展确实有很大的推进作用。不少人认为我们已进入了一个人工智能和深度学习的 “夏天”。可不是吗?就连谷歌的搜索引擎都会做“深度学习”的梦:当你在谷歌的搜索引擎里输入“Japanese cucumber farmer”(最后要输入一个空格), 你会发现谷歌会自动填加“deep learning”!

这到底是怎么回事?!日本的菜农跟深度学习能沾上什么边?谷歌搜索是热昏了头吗?点进去一看,才发现还真有一个日本的菜农下载谷歌的tensor flow来对九种黄瓜进行基于视频的自动分类,以实现其家庭农场的自动化!

天啦!如果农民都能够玩转深度学习,那还要我们这群科学家干什么?!只好回家卖红薯去了.

Now, I am very worried!

二、算法和技术的进展和突破

让我们先把我们的(自私的)担忧暂时放在一边,一起来看看人工智能这几年的突破性进展吧!

如果说近年来大数据、云计算、计算硬件和物联网等等架起了许多的柴火堆,那么深度学习正像是一桶油,浇在了这些火堆上, 让它们烧得更大、更猛、更热闹。

深度学习的算法已存在近二十年, 但只是最近几年才开始被广泛采用。尤其在图像识别领域取得了突破性进展。例如,谷歌相册在我的照片集中自动地找出了一百多种不同的事物,进行自动归类和标识。这种强大的模式识别能力确实是前所未有的。

2.1 人工智能正红火(AI is on fire)

在医疗领域,AI的火已经燃烧了有一些年头了。深度学习使这个火焰达到前所未有的高度和规模。或者,从另一个角度看,最近几年的激情和繁荣(exuberance)反映了对AI的期望的一个巨大的飞跃: 现在许多人正在急切地等待AI来(至少部分地)替换医生 -- 例如,诊断某些疾病; 或做出人类本来就做不来的一些高智能或大计算的任务-- 例如,基于大数据来选择最佳治疗或预测结果。

换句话说,业界有两种对近期前景的预测或期望:一个观点是“加速型进化”(accelerated evolution),另一个观点是“破坏性革命”(disruptive revolution)。

“加速型进化”早已悄然启动, 正在顺利前行。仅在医学成像领域,深度学习正在提升所有模式识别的能力,从解剖结构到疾病,以前所未有的速度提高工作流程和效率。

尽管AI已经给我们展示了精彩的表现和令人兴奋的成就,全面掌握了围棋和复杂的扑克游戏,医疗领域是否真的在面临着一个“破坏性的革命”的问题仍然让人有点琢磨不透, 难以预测,叫人有点无所适从。医生做的大多数工作是模糊的和不确定的,没有明确的规则,并缺乏可靠的训练数据。但是,这些困难好像并没有让那些“革命派”们胆怯或者退缩,他们在多条战线上赞助或推进雄心勃勃的“登月计划”(“moonshot”),吸引着大量的来自小型创业公司和大型集团的热心人士,以及来自世界各地的大学、研究机构和政府。

以前在AI领域工作的人,例如计算机视觉、模式识别、或者医学图像处理之类的领域,似乎更多地倾向于“加速型进化”的观点和说法,而新来的人则更倾向于预测一个“破坏性革命”。每一边都有自己的偏见,目前好像都不能轻易地说服另一边。

2.2 反观历史

既然未来难以预测,我们就反观一下历史吧,看看在过去的十几二十年来AI在医疗领域都有哪些成就,特别是在医学成像领域的成就。

我喜欢把我们在过去15年里的工作戏称为“成像智能”(imaging intelligence),因为我们做了一对i(“eye”眼睛), 把它们做到了医疗成像仪器上去,如CT和MRI,也放进了放射科和心脏科的后处理工作站上。在“成像智能”的两只眼睛中,一只专注于看疾病,这也就是传统的CAD(computer aided detection 计算机辅助检测)领域;另一只眼睛将专注于看解剖结构,例如我们早在2006年做得产品ALPHA (automatic landmarking and parsing of human anatomy) 人体解剖学的自动标识和解析。

CAD这个领域在2005年到2015年之间经历了一些艰难的时期,皆因过度承诺overpromise最终导致负面新闻(说来话长,按下不表)。而ALPHA从一开始就走上了快速增长的道路。 两者都随着今天的AI浪潮水涨船高,如果将两个合并,预计增长势头会更猛更快。

在过去十几年里,基于机器学习的对人体解剖结构的自动检测在医学成像领域得到了广泛的应用。CT和MRI机器能够从预扫图中自动找到各种解剖结构, 然后非常精准的对目标结构(比如说大脑)进行成像,同时减少对相邻敏感器官(比如说眼角膜)的不必要的伤害(见下图a-e)。

我们最初以为检测解剖结构应该比检测疾病要容易得多,后来才发现并非如此。 在医学成像领域里, Anomaly is the norm (非常乃正常), 疾病(比如说肺部积水)经常影响解剖结构 (比如说心脏,见下图)。而恰恰是在这些情况下,算法必须正常工作才能有足够的商业价值。

解剖结构检测的问题非常多样化, 机器可以标识解剖结构,分割器官边界, 跟踪器官运动, 以及提供各类测量。一个突出的例子是对脊椎骨和肋骨的鲁棒检测, 逐个标识和虚拟拉直 (见下图)。

这一类的工具可以帮助技术员们大大提高成像的质量、速度、一致性(consistency)和重现性(reproducibility)。一致性(consistency)指的是不同的技术人员扫描同一病人出来的图像应该是一样的。重现性的一个例子是,比如说六个月以后所照的膝盖磁共振图片应该与六个月之前的图片正好切在同一个解剖平面上,这样才能看清楚六个月的治疗的真实效果, 并帮助放射医生更快更好地处理分析图像和撰写报告。

解剖结构检测这个领域仍然是前途无量的。人类光骨头就有206根(正常情况下), 还有无数的血管、神经、淋巴以及非常复杂的器官和结构。如果再考虑到所有那些不同的成像模式 -- 超声、X射线、CT、MRI、正电子发射断层扫描(PET)等等, 组合起来的领域分支就更多了。

而深度学习则进一步拓展了我们的视野,并且大大提升了我们的期望值: 以前难以想象的任务,例如,从大数据中同时学习多种解剖结构和多种疾病,现在是不是都可以轻松实现了呢?

当然,深度学习也被用于重写许多先前的用于罕见事件(rare event)或上下文事件(contextual event) 的检测算法。但是,人们不应该简单地认为深度学习在所有情况下都会更好更强大;或者我们需要用深度学习去重新尝试一些已经解决得很好的问题。我们在2000年初开发的用于检测和跟踪心脏运动并估计射血分数(Ejection Fraction)的算法,这些年以来在现实应用当中工作得很好;还有我们的肺结节检测算法也经受住了时间的考验:发表在2016年10月刊的Radiology杂志上的一篇独立研究[1]发现我们十年前的算法现在仍然是行业领先。

我们确实也试过用深度学习来解决这些经典的问题,但我们发现简单和直接的去用它好像通常不会产生神奇的结果,而是需要增加一些额外的语义建模层(semantic modeling layers)来提高精准度。我在下一章中会对这类问题进行更详细的论述。

三、商业化的路障和挑战

李开复老师最近说:“如果在座有孩子想去读医学影像的识别,就是帮助你看片子的那些医生,千万不要,五年以后没有人会做这个行业了,全部被机器取代”。伊隆·马斯克(Elon Musk) 做过一个大胆的预测,称全自动驾驶即将在几年内实现。正是这一类的宣言和信念在推动风险资本对AI领域的高度期望和投资,并已经达到了史无前例的程度。

因此,一个关键问题是:机器会很快(比如说, 5年内) 在一些关键任务上替代人类吗? 比如全自主驾驶, 或全面替换放射科医生?如果答案是否定的,或者时间框架是在十年或者二十年之外,而不是五年,那么许多风险投资人将会大大失望,有些甚至可能会马上撤资。即使在这10-20年内,AI带来惊人的技术进步,帮助人类完成许多高难度的任务,并为投资者带来大量的利润,所有这些可能都不足以匹配当前投资界对AI的既高又广的期望。

那么,今天的主要障碍或挑战到底是什么,会阻止计算机算法在5年内实现全自动化驾驶和自动阅读所有CAT(计算轴向断层扫描)图像的宏伟梦想?

3.1 小猫(cat)还没搞定,就想挑战“大猫”(CAT: computed axial tomography计算轴向断层扫描)?

学会在照片中找到猫是深度学习的一个标志性的成功故事。该算法确实比人类快,但是它明显比人类好吗?这种算法是真的能够找到“所有的猫,而且只有猫”(“all the cats, nothing but the cats”)吗?谷歌相册,通过深度学习,把我妻子的一张照片放到了“猫”的文件夹中(见下图)。所以,要么是我不小心娶了猫女,要么就是今天的深度学习算法仍然会犯愚蠢的错误。事实上类似的错误还很多,不管是找猫还是找其他的东西。

如果小猫(cat)都还没有搞定,我们真的可以把所有的“大猫”(CAT: computed axial tomography 计算机轴向断层扫描) 图像都完全托付给AI吗?再次强调一下,我们在此讨论的是“所有CAT图像”和“5年之内”。我可以设想“小猫算法”在5年内会有大幅度的提高,达到接近完美的敏感性和特异性。我也可以设想,在5年内,会快速的出现一批医学图像分析的任务是由机器来完成, 而且不需要放射科医生来监督。但是,绝对不会是所有的任务。

同时我也认为这只是一个“进化”而不是“革命”,因为多年来,计算机已经可以完全自动地阅读心电图,半自动地阅读宫颈刮片图,和独立承担许多实验诊断学的测试项目。

3.2 AI从第L2级到第L3级的飞跃尚未实现

虽然我们有雄心勃勃的愿景,还有商业界强力的推动,第L3级的自动驾驶今天还没有真正实现。第L3级的自动驾驶是允许司机不用再看着前方的道路的,可以写写电子邮件, 读读书,或者甚至打个盹(你必须要考虑到很多人一读书就可能打瞌睡)。我觉得这很有可能在5年内实现,但是只会在一些特定的驾驶条件下才会工作,比如说高速公路,并且没有特别恶劣的天气。不管怎么样,光保险公司就可能需要五年才能琢磨出来怎么样量化各种各样的风险:AI犯错的机会必须要足够小,以至于从汽车制造商或车主那里收集来的保险费可以足够弥补。或者,也可以想象一些新的商业化方法,例如使用人来远程监视100辆汽车,万一某个打瞌睡的客户没有及时被AI的“请立即接管驾驶任务!(please take over now!)” 的请求闹醒, 监视中心的人可以随时远程接管驾驶任务,让汽车安全地脱离危险。这个商业模式有点像今天的一些家庭安全公司的做法,或者可以看成为一种 “实时的道路救援服务”(real-time road side assistance service)。

Mobileye的Amnon Shashua博士预测第L3级自动驾驶的到来会在2018 - 2020年左右,而BMW则好像是把第L3级预计在2020年以后上市,第L4/L5级 则被推到了2025年之后。任何在工业界或金融领域工作的人都知道,长期预测通常带有很大的误差,且常常是偏于乐观的。

回到放射学领域,现有的CAD(计算机辅助检测)算法已经商业化很久了,但还停留在对应于自动驾驶的第L1/L2级上,只是担当“第二读者”(second reader):医生需要对图像的采集和分析负全部的法律责任,算法仅仅是提供帮助/辅助。

第L3级的AI意味着算法需要开始负起责任来,成为“第一读者”(first reader), 而且经常会是“唯一读者”。再次强调前述观点:这算不上是一场 “革命”,因为它在诸如心电图监测,宫颈涂片和一些病理图像自动分析的任务中已经被用了很长时间了。利用深度学习的力量,我可以想象在未来5年中会涌现出一大批新的“第一读者”产品。肺结节或结肠息肉检测算法将首先全面地分析所有的图像,而放射科医生只需要审核一下那些算法找到的可疑的病变区域。计算机将分析所有的胸部X射线图像,并且直接向临床医生指出哪一些人可能有病变,而把那些看上去正常的健康的人直接送回家。

与第L3级的自动驾驶的情况类似,商业化成功的关键在于对算法出错风险的量化和控制:每一个错过的结节或息肉的成本是多少?或者错误地把一个病人当做健康人送回了家的风险成本又是多少?错误率不需要为零,但必须足够低 -- 至少得低到保险单能够支付得起的地步。或者,我们可以给那些由计算机送回家的“健康患者”们提供一个“专家确认”的服务:如果他们真的想要更确定的话,他们可以付额外的费用请人类专家再看一遍。但是这种额外收费的方法,尽管经济上是合理的,可能会面临“政治正确”的挑战:“你是说富人可以得到人类专家的悉心呵护,而穷人就可以死在机器人的冰凉冷酷的手里吗?!” 如果所有图片都要人类专家过目一遍的话,那我们就又退回到第L2级去了。

多年来,我们一直在寻找计算机视觉和模式识别的“杀手级应用程序(Killer Application)”。现在我们至少有两个:自动驾驶和放射学。这两个都是真正的 “杀手(Killer)”级应用程序:如果机器犯个严重的错误(例如,将白色卡车误认为白云,或将肺癌误认为是肝脏的一部分),它可能真的会 “杀人”。

如果你经常开车的话,我建议你选一天,一路上不断地,有意识地问自己,“这一段路能让AI开吗?” 一天下来,你可能就会觉得AI五年之内不可能完全自己开车。同样的道理,如果你跟踪一个临床医生或者一个放射科医生一整天的话,你同样可能意识到他们的很多任务都是不可能被AI在五年内代替的,二十年都不可能。

一个非常有趣的民意调查显示,人们往往相信其他人的工作可能会被AI替代,但不包括他们自己的工作!这可以解释“每个工作都将被AI替代, 每个工作都不会被AI替代”的“AI预测悖论”:你会听到许多预言家讲许多工作将被AI替代,所有这些预言的总和就是 “所有工作都会被AI替代”;但是当你去逐一分析每个工作的时候 --如果你可以相信那些做这个工作的、熟悉该工作的人 -- 同样的预言家会告诉你这个工作将不会被AI替代,至少不会在5年之内, 或者甚至不会在二十年之内。

无论事实如何,有一点是肯定的:如果你不了解一个工作的细节,不要轻易预测“它将在5年内被AI取代”。

3.3 “只要有足够的数据,任何问题都会迎刃而解!” 这是真的吗?“Give me data, I can do anything!”Really?

因为它强大的“端到端(end-to-end)”的学习功能,深度学习正带来一场革命。“只要收集到足够的数据,并告诉它你想要什么结果,深度学习都能学到”已成为很多人的期望。这个说法在很多情况下是成立的,但不是所有的情况 -- 让人担忧的是有一些极其简单的问题都会难倒它。

下面这个例子就是这个情况:

这个例子我们稍微仔细看一下就会发现其中的逻辑其实很简单:第一类是“不同形状的组合”,而第二类是“单一形状的组合”。所以答案应该是“第一类”。

有意思的是,如果直接应用深层神经网络,以端到端的方式来解决这个问题,不管你用多少训练数据都训练不出来。那么人是怎么解决这个问题的呢? 我们是先看到形状,识别了各个形状,然后再做逻辑推理。所以算法上只要加一两个简单的算法模块,首先做图像分割和形状识别,接下来这个问题就迎刃而解了。

人类一些疾病也有类似的复杂逻辑在里面:某些CT图像的一些形态(例如,肺中的 “蜂窝”病灶)可能预示某一种疾病A(例如,UIP普通间质性肺炎),然而,另一些图像形态(例如GGO或磨玻璃样病灶)的共存可能排除疾病A,并大大提升另一疾病B的可能性(例如,NSIP或非特异性间质性肺炎)。

在我们最近的针对间质性肺病的CAD工作中,端到端训练完全不能解决问题。而添加了一些分步逻辑模块之后,例如肺部分割和对局部疾灶模式的学习,我们开始找到解决问题的眉目了。我们做了一个算法的原型,可以达到一个刚入门的放射科医生的水平,并且可以帮助他们检测到更多的疾病病例。我预计,在5年内,这个算法应该能够达到或超过专家级的放射科医生的水平,并且许多类似的算法和工具也将陆续上市。

但是这种手工定制逻辑模块的做法, 不容易实现有工业规模的快速成长(industrialized scale-up)。如果我们再考虑到人类疾病的总数是如此之大(约30,000),我们就会意识到“人工智能在五年内会全面替换放射科医生”的说法确实是太过于乐观了 -- 我认为二十年都不太可能。因为我们都知道啃不动的硬骨头都会留到最后,所以最后百分之五的工作往往会花掉我们百分之五十的总预算,甚至更多!

四、结语

很奇怪,多年来,我都没有意识到AI正是“爱”字的拼音。就让我用下面这两个简单的句子来结束这篇文章吧:

AI is Love, Love AI。 AI会给世界带来更多的爱, 让我们爱AI。

沪公网安备 31011502009854号

邮箱: service@yingtongshe.com 地址: 上海市浦东新区新金桥路58号银东大厦15B室

沪公网安备 31011502009854号

邮箱: service@yingtongshe.com 地址: 上海市浦东新区新金桥路58号银东大厦15B室